Les cartes cadastrales comptent parmi les représentations historiques structurées les plus complexes, d’où l’apparition tardive de cette technologie. La richesse des informations contenues dans ces sources les rendent indispensables pour les Humanités digitales et la reconstitution historique. De plus, la nature mathématique de la cartographie la rend facilement compatible avec le numérique. Depuis plusieurs années, historiens et géographes œuvrent à la vectorisation manuelle des cartes historiques. Le processus de vectorisation consiste à redessiner un à un les éléments géométriques de la carte (routes, limites des parcelles, bâtiments, etc.) dans un système d’information géographique (SIG). Dans un deuxième temps, des attributs peuvent être ajoutés à cette représentation informatique de la carte, tels que les numéros de parcelles. Ce processus rend finalement la carte historique numériquement intelligible et, surtout, cherchable. Par exemple, les cartes qui apparaissent dans les moteurs de recherche tels que Google maps, Mapbox ou OpenStreetMap sont des cartes vectorielles. Le problème, par conséquent, si nous voulons créer des bases de données qui nous permettent de récupérer et d’accéder à l’information géohistorique, est principalement un problème de vectorisation. Il convient de noter que, si cette tâche est techniquement possible avec la technologie actuelle, la vectorisation manuelle d’une carte historique est un processus extrêmement long, qui prend généralement plusieurs semaines pour une seule carte. Par conséquent, compte tenu des centaines de milliers de feuilles existantes, l’extraction manuelle de l’ensemble des géodonnées du passé n’est tout simplement pas réaliste.

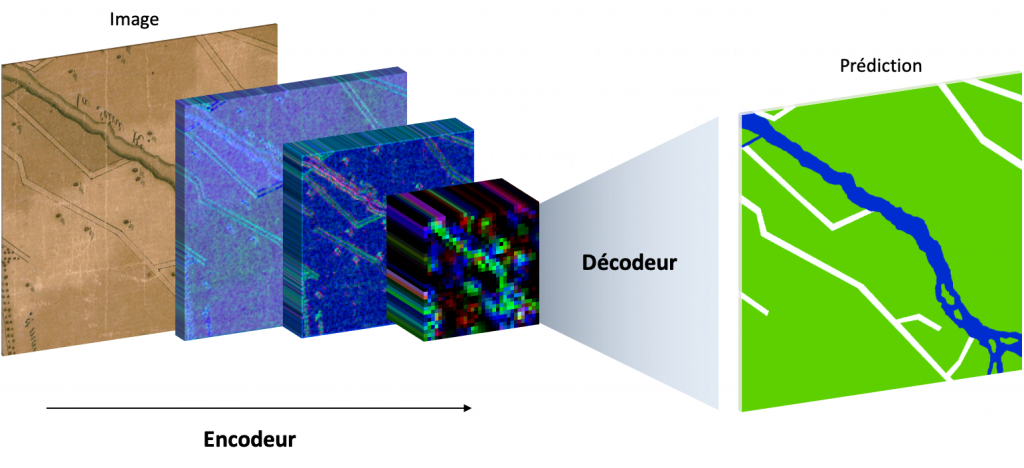

En 2019, Oliveira, di Lenardo, Tourenc et Kaplan ont proposé une nouvelle méthode révolutionnaire pour vectoriser automatiquement le cadastre napoléonien de Venise en utilisant une technologie d’intelligence artificielle (IA) basée sur des réseaux de neurones convolutifs. Derrière ce terme se cache un objet mathématique composé de nombreuses fonctions, dont chacune comprend des milliers de variables. Chaque variable est potentiellement couplée à un coefficient, appelé poids. Il est possible d’ajuster les poids d’un réseau de neurones avec une grande sensibilité pour résoudre presque tous les problèmes de reconnaissance d’images, ou des problèmes plus complexes, tels que la segmentation des objets ou la segmentation sémantique. C’est la capacité à résoudre ce dernier type de problèmes qui est utilisée pour segmenter les cartes historiques. Pour atteindre ce résultat, il est nécessaire d’entraîner le réseau à résoudre le problème en question. Le déroulement de cette phase est très intuitif car cela consiste simplement à présenter au réseau un nombre relativement important d’exemples, contenant à la fois la question – dans notre cas un extrait de carte – et la solution attendue – dans le cas présent, la segmentation sémantique, qui peut se rapporter simplement à colorer les bâtiments d’une couleur et le réseau viaire d’une autre couleur. Peu à peu, à mesure que le réseau neuronal apprend des exemples, il devient capable de résoudre lui-même le problème sur des cartes qu’il n’a jamais vues. Il acquiert donc une capacité d’inférence.

Plus surprenant encore, les réseaux neuronaux sont capables, lorsqu’ils y sont contraints, de comprendre des concepts complexes de morphologie, de topologie et de hiérarchie sémantique. Ces concepts très avancés permettent à l’IA d’identifier les bâtiments sur une carte qui n’offre aucun indice visuel autre que les contours, par exemple une carte en noir et blanc sans texture. Ainsi, il est possible d’entraîner des réseaux génériques capables de lire à peu près n’importe quelle carte de ville. D’autre part, il est également possible d’entraîner des réseaux spécialistes sur des cartes dont la grammaire et la représentation sont régulées, comme le cadastre napoléonien.

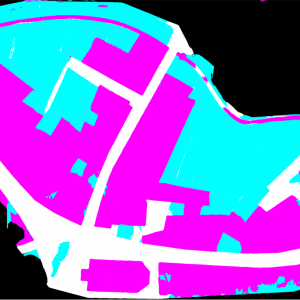

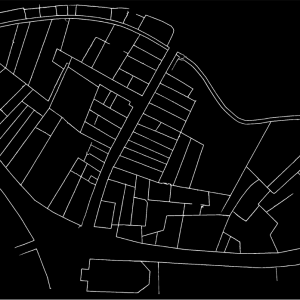

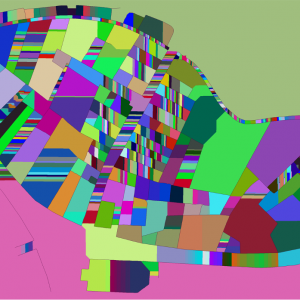

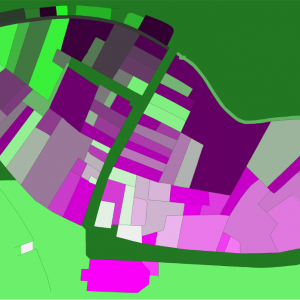

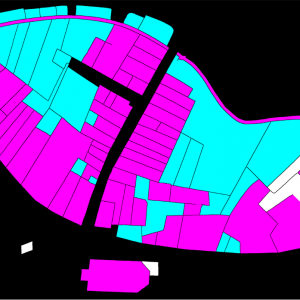

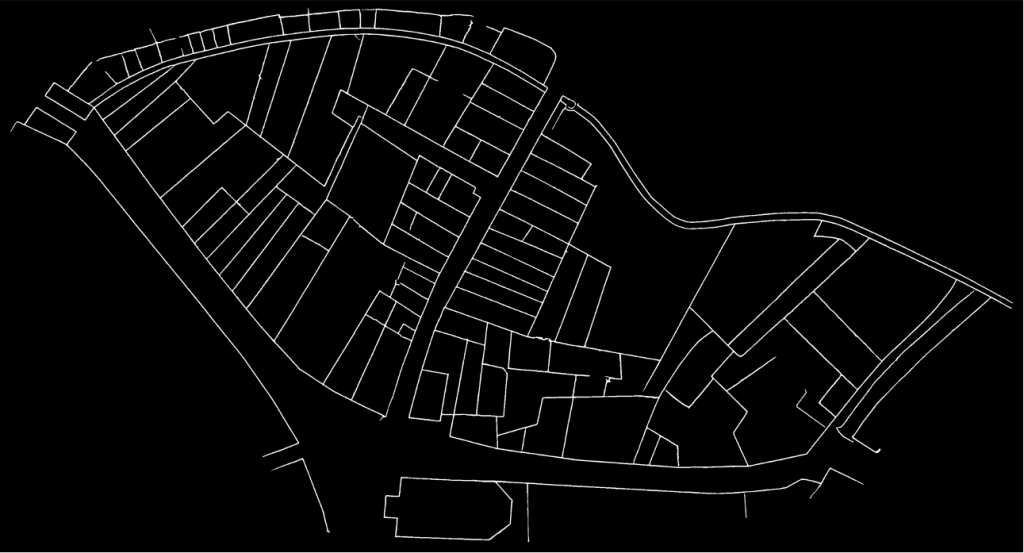

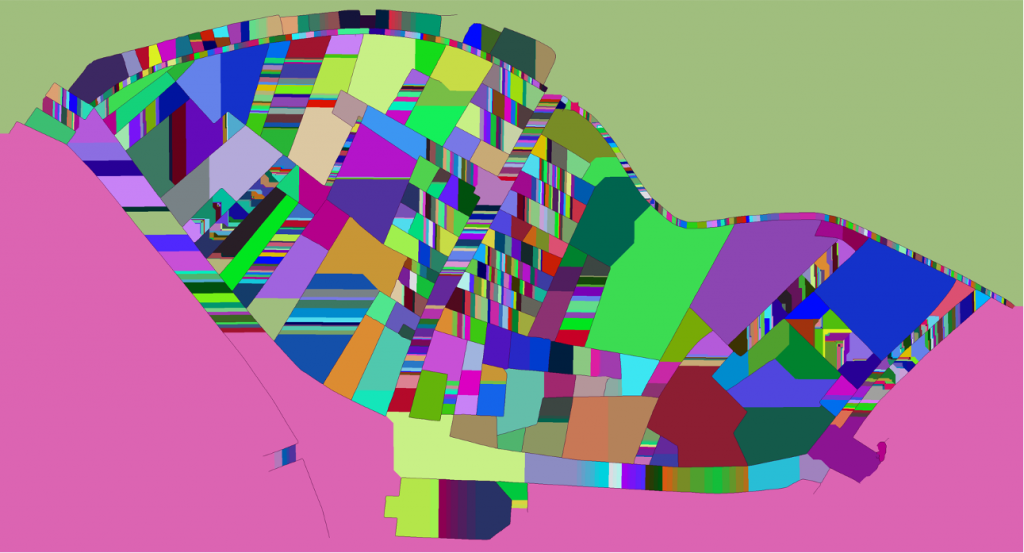

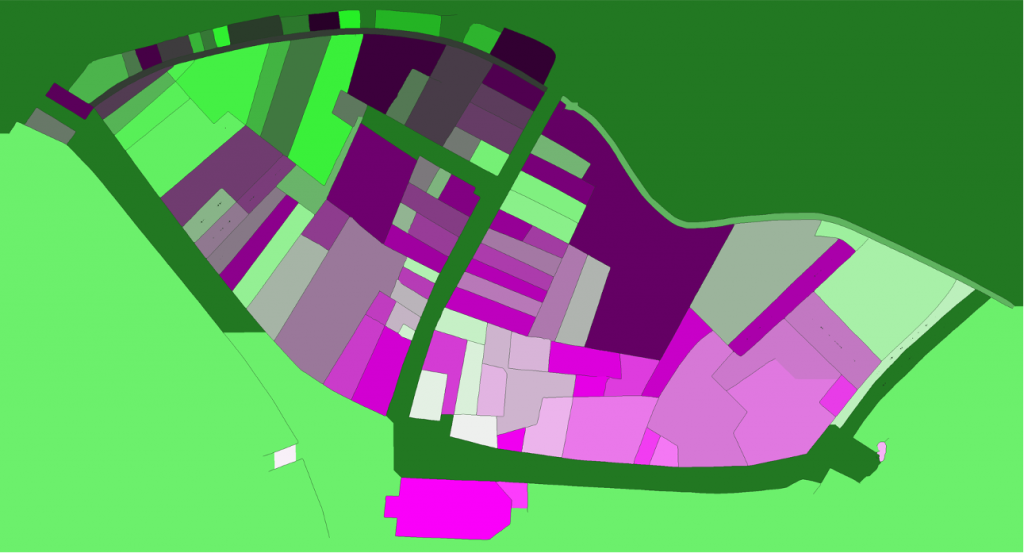

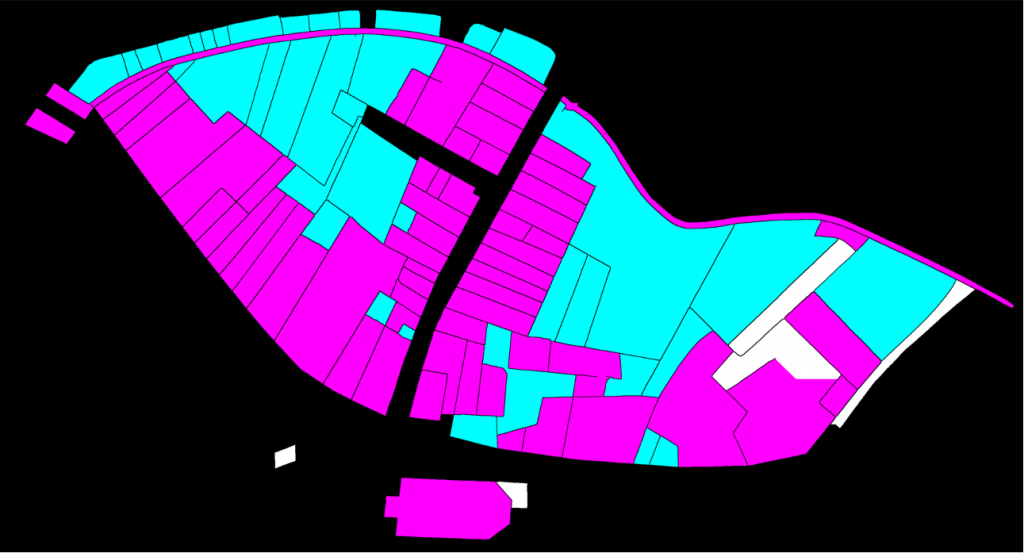

Une stratégie consistant à pré-entraîner le réseau sur un corpus générique avant de le forcer à se spécialiser a été utilisée pour vectoriser les cadastres lausannois de Berney (1831) et de Melotte (1727). Plusieurs centaines de cartes de la ville de Paris, figurativement hétérogènes, ont d’abord permis au réseau neuronal d’acquérir une souplesse de représentation et d’intégrer des notions topologiques complexes. Dans un deuxième temps, un nombre limité d’exemples extraits de chacun des deux cadastres lausannois a été produit manuellement et de très bonnes prédictions ont été rapidement fournies par le réseau. Le problème de la vectorisation est divisé en deux sous-problèmes. Le premier vise à identifier le contour des objets représentés, et donc à découper les parcelles cadastrales. Le second problème vise à sémantiser la nature les parcelles, par exemple en tant que réseau routier, zone non-bâtie, plan d’eau ou contenu non cartographique (par exemple le cadre de la feuille sur laquelle la carte est dessinée). Un troisième réseau de neurones (Sasaki 2017) est également utilisé pour compléter les lignes potentiellement mal reconnues ou interrompues.

Au final, couplée à un post-traitement adapté basé sur l’algorithme watershed et la fusion des superpixels, cette méthode a permis de vectoriser efficacement, en annotant à peine 5% du corpus, plus de 94% des parcelles des cadastres Berney et Melotte, et d’obtenir ainsi une version numérique de ces documents historiques utilisable pour la reconstitution, mais aussi pour des analyses urbaines sur le développement de la ville, ainsi que sur son organisation urbanistique et sa morphologie.

Pour plus d’informations

Petitpierre, Rémi. “Neural Networks for Semantic Segmentation of Historical City Maps: Cross-Cultural Performance and the Impact of Figurative Diversity,” 2020. https://doi.org/10.13140/RG.2.2.10973.64484.

Petitpierre, Rémi. “4000 cartes par jour : des réseaux de neurones artificiels pour récupérer les géodonnées du passé.” Billet. Carnet de la recherche à la Bibliothèque nationale de France (blog), August 31, 2020. https://bnf.hypotheses.org/9676.

Ares Oliveira, Sofia, Isabella di Lenardo, Bastien Tourenc, and Frédéric Kaplan. “A Deep Learning Approach to Cadastral Computing.” Utrecht, Nederlands, 2019. https://dev.clariah.nl/files/dh2019/boa/0691.html.

Long, Jonathan, Evan Shelhammer, and Trevor Darrell. “Fully Convolutional Networks for Semantic Segmentation.” ArXiv:1411.4038 [Cs], March 8, 2015. http://arxiv.org/abs/1411.4038.

Sasaki, K., S. Iizuka, E. Simo-Serra, and H. Ishikawa. “Joint Gap Detection and Inpainting of Line Drawings.” In 2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), 5768–76, 2017. https://doi.org/10.1109/CVPR.2017.611.